La Inteligencia Artificial está transformando la forma en que trabajamos, decidimos y nos relacionamos.

Pero mientras la tecnología avanza a una velocidad sin precedentes, surge una pregunta clave:

¿podemos confiar en ella?

Más allá de la precisión de los algoritmos o la eficiencia de los sistemas, el verdadero reto está en cómo aseguramos que la IA sirva a las personas y no al revés.

En la era digital, la confianza no es un valor accesorio: es la base sobre la que se construye toda innovación sostenible.

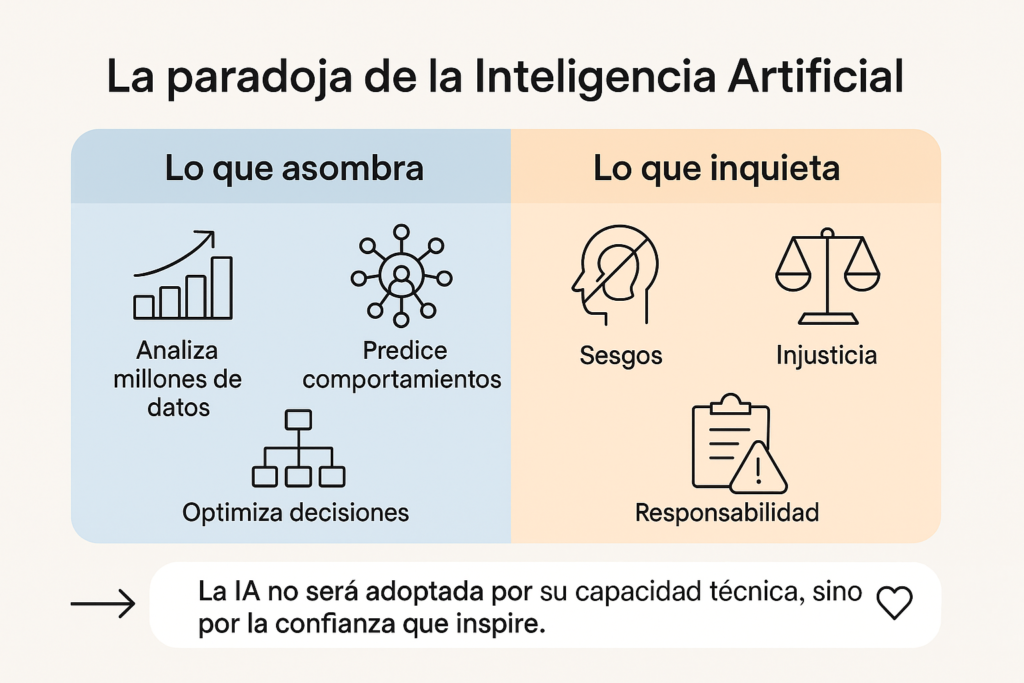

La paradoja de la confianza tecnológica

La IA ofrece soluciones asombrosas: analiza millones de datos, predice comportamientos, optimiza decisiones.

Sin embargo, también genera inquietud: ¿qué pasa con los sesgos? ¿Quién responde si una decisión automatizada es injusta?

Esta paradoja —admiración y desconfianza al mismo tiempo— se resume en una idea clave:

👉 La IA no será adoptada por su capacidad técnica, sino por la confianza que inspire.

Según Edelman Trust Barometer (2024), el 68% de los empleados teme que la IA pueda usarse de forma poco ética.

El problema no es la tecnología, sino la falta de transparencia y gobernanza.

Por eso, construir una IA responsable significa liderar con ética, no solo con datos.

Qué significa una IA ética en la empresa

Una IA ética no es una utopía filosófica: es una práctica corporativa que combina tres principios esenciales:

a. Transparencia

Explicar cómo funcionan los algoritmos, qué datos utilizan y para qué se aplican.

La opacidad genera sospecha; la claridad genera confianza.

Ejemplo: cuando una empresa comunica abiertamente cómo la IA evalúa candidatos o sugiere decisiones, los empleados y clientes se sienten más seguros.

b. Justicia y no discriminación

Los algoritmos aprenden de datos históricos… y los datos reflejan los sesgos humanos. Si no se corrigen, esos sesgos se amplifican.

Por eso, las empresas deben auditar sus modelos y diversificar los equipos que los desarrollan.

La ética se entrena igual que un modelo: a través de revisión constante y aprendizaje continuo.

c. Responsabilidad humana

La IA puede asistir en la toma de decisiones, pero la última palabra debe ser humana.

Delegar completamente en la máquina es abdicar del juicio ético.

En palabras de Tim Cook, CEO de Apple:

“La tecnología tiene un propósito, pero la responsabilidad sigue siendo humana.”

Casos reales: cuando la ética impulsa la innovación

Microsoft y la IA responsable

Implementó un comité de ética interna (“AI, Ethics, and Effects in Engineering and Research”) que revisa todos los proyectos con impacto social.

Esto ha permitido desarrollar sistemas más inclusivos y transparentes, generando confianza entre clientes y empleados.

BBVA y la banca con IA ética

Desarrolló un marco de “IA explicable” para que cualquier decisión automatizada —como un crédito o recomendación— pueda ser entendida y auditada.

El resultado: más aceptación por parte de clientes y reguladores.

Airbus y los algoritmos auditables

Creó un sistema de IA para mantenimiento predictivo que incluye trazabilidad de decisiones: cada predicción puede ser revisada, garantizando responsabilidad técnica y ética.

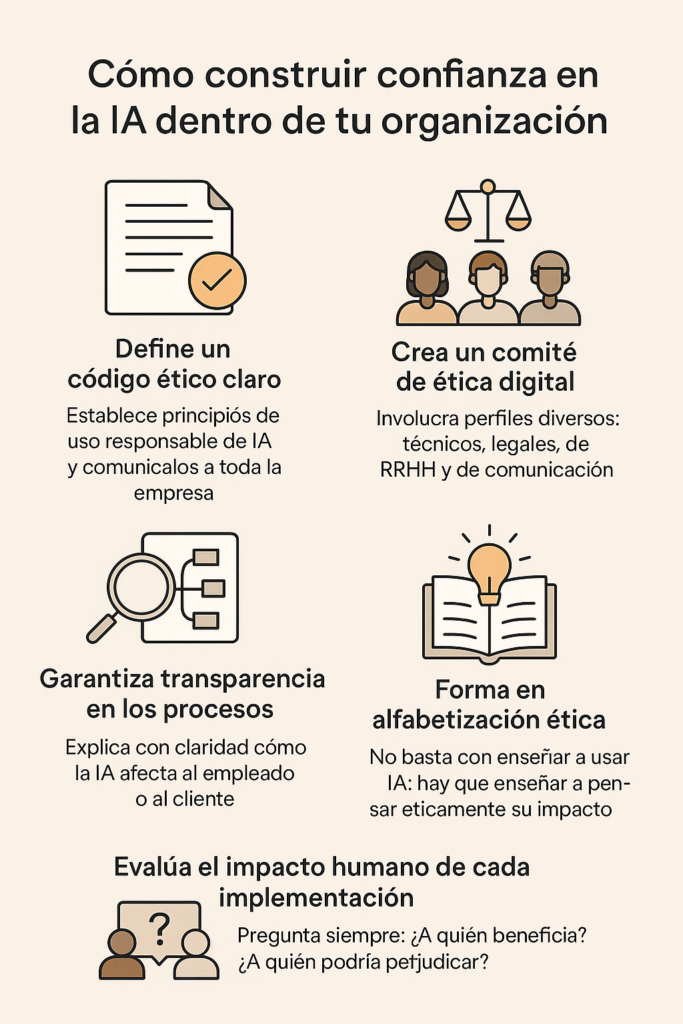

Cómo construir confianza en la IA dentro de tu organización

- Define un código ético claro.

Establece principios de uso responsable de IA y comunícalos a toda la empresa.

- Crea un comité de ética digital.

Involucra perfiles diversos: técnicos, legales, de RRHH y de comunicación.

- Garantiza transparencia en los procesos.

Explica con claridad cómo la IA afecta al empleado o al cliente.

- Forma en alfabetización ética.

No basta con enseñar a usar IA: hay que enseñar a pensar éticamente su impacto.

- Evalúa el impacto humano de cada implementación.

Pregunta siempre: ¿a quién beneficia? ¿a quién podría perjudicar?

El liderazgo ético como ventaja competitiva

La confianza no se delega al departamento de cumplimiento, se construye desde el liderazgo.

Los líderes que comunican sus decisiones con transparencia y promueven una cultura de responsabilidad tecnológica generan compromiso y reputación.

La ética, lejos de frenar la innovación, la potencia:

- Mejora la aceptación interna.

- Fortalece la imagen de marca.

- Reduce riesgos regulatorios.

- Aumenta la fidelidad de clientes y talento.

Porque en un mercado saturado de datos, la confianza se convierte en el diferenciador más escaso y valioso.

La confianza como moneda del futuro

En el siglo XX, el valor de una empresa se medía por sus activos tangibles.

En el siglo XXI, se medirá por la confianza que inspire en su uso de la inteligencia artificial.

Los consumidores, inversores y empleados ya no solo preguntan qué hace la empresa, sino cómo lo hace.

Construir una IA ética no es una obligación regulatoria: es una estrategia de sostenibilidad humana y empresarial.

Y las compañías que la adoptan liderarán no solo el mercado, sino la conciencia colectiva del futuro.

Conclusión: ética para que la IA siga siendo humana

La ética no es el freno de la innovación, sino su dirección.

La confianza, más que un valor blando, es una ventaja competitiva tangible.

Y cada decisión ética en torno a la IA refuerza lo que ninguna tecnología puede programar: la integridad y la humanidad en el trabajo.

Si buscas optimizar la formación de tus empleados, puedes ponerte en contacto con nosotros.