La inteligencia artificial avanza más rápido que nunca. Pero su adopción real depende de un factor mucho más humano: la confianza.

Las organizaciones que gestionan la IA sin ética, transparencia ni cuidado de los datos están construyendo sobre terreno inestable. En cambio, las que la implementan con responsabilidad, convierten esa confianza en una ventaja competitiva, reputacional y de talento.

Este artículo te muestra cómo integrar una IA ética y segura en la cultura de tu empresa, sin frenar la innovación.

¿Por qué hablar de IA responsable no es opcional?

1️⃣ El contexto regulatorio se acelera

Europa ya lidera con la AI Act, el primer marco legal integral sobre inteligencia artificial. Este regula el uso según el nivel de riesgo, desde sistemas críticos (salud, transporte, contratación) hasta usos de bajo impacto.

Las empresas deberán documentar, auditar y garantizar la trazabilidad de sus modelos.

2️⃣ El riesgo reputacional es real

Un error algorítmico, una filtración de datos o una recomendación sesgada pueden destruir años de confianza.

Los usuarios y empleados esperan que la IA mejore su experiencia, no que la comprometa.

3️⃣ La ética se convierte en marca

Las compañías que actúan con responsabilidad —desde la transparencia de sus algoritmos hasta la gestión de datos personales—, fortalecen su marca empleadora y su propuesta de valor.

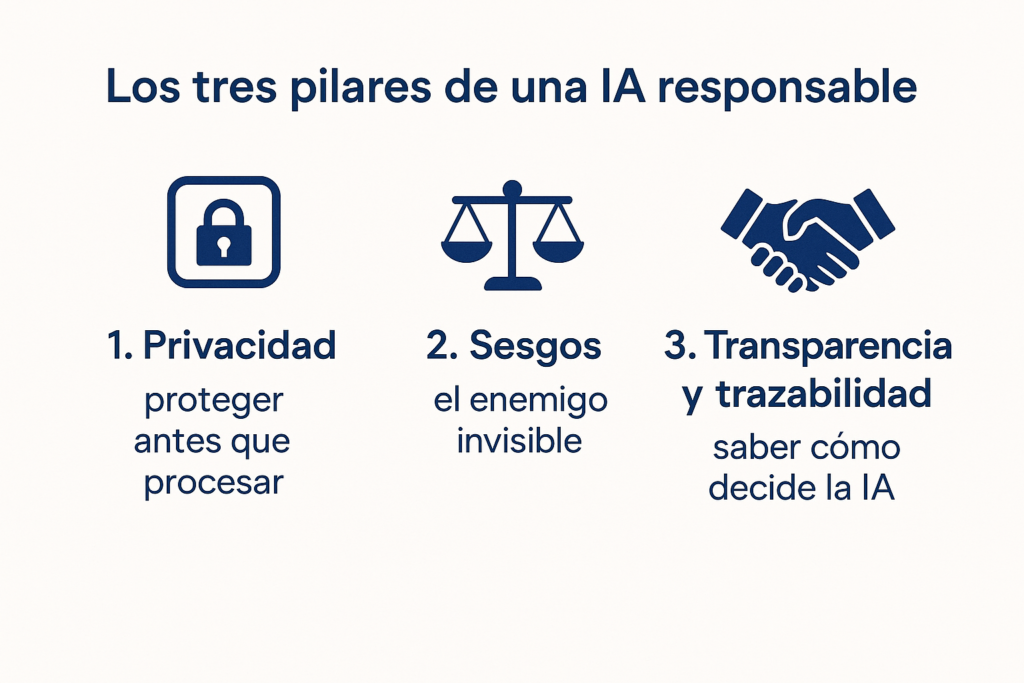

Los tres pilares de una IA responsable

🔒 1. Privacidad: proteger antes que procesar

La IA responsable comienza con una premisa clara: los datos son de las personas, no de la empresa.

- Revisa políticas de acceso y almacenamiento;

- Elimina información sensible antes de entrenar modelos;

- Comunica de forma transparente cómo se usan los datos.

💡 Ejemplo corporativo: una entidad financiera entrenó su IA de la atención al cliente solo con datos anonimizados y logró mantener la precisión del modelo sin comprometer la privacidad.

⚖️ 2. Sesgos: el enemigo invisible

Los modelos aprenden de los datos… y los datos reflejan nuestras desigualdades.

Un sistema puede recomendar candidatos, créditos o contenidos reproduciendo los sesgos históricos.

Cómo mitigarlos:

- Diversifica los equipos que diseñan y validan modelos;

- Revisa periódicamente los resultados (no basta con un test inicial);

- Establece métricas de equidad, no solo de precisión.

💡 Ejemplo: una empresa tecnológica corrigió su modelo de selección al detectar que penalizaba inconscientemente perfiles femeninos en áreas técnicas. La revisión aumentó un 18 % la diversidad en nuevas contrataciones.

🤝 3. Transparencia y trazabilidad: saber cómo decide la IA

No basta con obtener “buenos resultados”; es imprescindible explicar cómo se generan.

- Mantén registro de versiones, datos y cambios en los modelos;

- Permite auditar procesos internos;

- Comunica decisiones automatizadas de forma comprensible.

💡 Ejemplo: una compañía de seguros creó un panel interno donde cualquier empleado puede ver cómo la IA pondera variables en la evaluación de riesgos. Resultado: más confianza y más adopción.

Cómo incorporar la ética al día a día

1️⃣ Define un comité de IA responsable con perfiles de RR. HH., legal, tecnología y comunicación.

2️⃣ Crea un código ético de IA (breve, práctico, visible).

3️⃣ Capacita a los equipos: enseñar a usar la IA incluye enseñar a cuestionarla.

4️⃣ Evalúa cada proyecto IA con tres preguntas:

IA responsable + IA práctica = adopción sostenible

La confianza no se impone; se construye con claridad, comunicación y coherencia.

Cuando los empleados perciben que la IA respeta sus datos y decisiones, la usan con más seguridad y creatividad.

Y cuando los clientes entienden que los sistemas son justos y auditables, la marca gana legitimidad y diferenciación.

Caso corporativo: confianza que escala

Una empresa del sector salud implementó un programa de IA responsable basado en tres acciones:

- Comité ético multidisciplinario.

- Transparencia activa con pacientes sobre el uso de IA diagnóstica.

- Formación en sesgos inconscientes.

En un año, logró un 35 % más de confianza de los pacientes y un 20 % más de adopción interna de las herramientas inteligentes.

Conclusión

La IA responsable no es una exigencia regulatoria: es una estrategia de sostenibilidad y reputación. Las empresas que priorizan privacidad, equidad y transparencia no solo evitan riesgos: crean confianza, talento y futuro.

Porque en la era digital, la ética no frena la innovación… la acelera.

Si buscas optimizar la formación de tus empleados, puedes ponerte en contacto con nosotros.